- 248

- 8

-

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v5.40.69.02 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v5.56.53.81 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v1.07.26.92 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v7.39.77.99 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v3.11.09.02 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v3.86.26.43 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v8.28.81.56 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v1.12.63.14 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v8.50.40.16 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v7.87.19.55 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v2.37.28.52 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v7.64.82.07 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v0.31.15.15 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v6.29.94.68 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v7.19.75.95 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v1.14.53.63 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v6.45.06.56 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v3.01.03.72 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v1.79.54.21 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v9.41.74.54 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v7.78.44.58 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v4.48.76.81 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v6.80.20.92 安卓版

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

v5.21.84.14 安卓版

| 分类:单机 / 冒险解谜 | 大小:3.4MB | 授权:免费游戏 |

| 语言:中文 | 更新:2025-12-02 09:23 | 等级: |

| 平台:Android | 厂商: 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进股份有限公司 | 官网:暂无 |

|

权限:

查看

允许程序访问网络. |

备案:湘ICP备2023018554号-3A | |

| 标签: 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进最新版 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进中文版 | ||

- 详情

- 介绍

- 猜你喜欢

- 相关版本

内容详情

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进游戏介绍

⚾2025-12-02 11:41 「百科/秒懂百科」【 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进】🍓支持:32/64bi🐯系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

🏈2025-12-02 09:45 「百科/秒懂百科」【 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进】🍌支持:32/64bi🦈系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

🏊2025-12-02 09:23 「百科/秒懂百科」【 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进】🐳支持:32/64bi🍒系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

🦈2025-12-02 07:18 「百科/秒懂百科」【 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进】🐰支持:32/64bi🐍系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

🐬2025-12-02 11:56 「百科/秒懂百科」【 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进】🐙支持:32/64bi🥌系统类型:(官方)官方网站IOS/Android通用版/手机APP(2024APP下载)《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进版本特色

1. 🐪「科普」🏄 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进下载(2024全站)最新版本IOS/安卓官方入口v3.86.48.34(安全平台)登录入口🍁《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

2. 🤸「科普盘点」🐱 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进下载(2024全站)最新版本IOS/安卓官方入口v7.43.65.41(安全平台)登录入口🍁《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

3. 🍂「分享下」🚴 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进下载(2024全站)最新版本IOS/安卓官方入口v6.19.61.62(安全平台)登录入口🍁《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

4. 🏹「强烈推荐」🤼♀️ 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进下载(2024全站)最新版本IOS/安卓官方入口v6.06.38.99(安全平台)登录入口🍁《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

5. 🐪「重大通报」🏌️ 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进下载(2024全站)最新版本IOS/安卓官方入口v4.10.22.77(安全平台)登录入口🍁《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

6. 🐢「返利不限」🌳 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进下载(2024全站)最新版本IOS/安卓官方入口v7.38.70.07(安全平台)登录入口🍁《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

7. 🏐「欢迎来到」🏀 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进下载(2024全站)最新版本IOS/安卓官方入口v0.52.16.85(安全平台)登录入口🍁《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

8. 🌸「娱乐首选」🦆 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进下载(2024全站)最新版本IOS/安卓官方入口v3.40.81.41(安全平台)登录入口🍁《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

9. ⛳「免费试玩」🤾 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进官网-APP下载🎾🥑🦊支持:winall/win7/win10/win11🐦系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进下载(2024全站)最新版本IOS/安卓官方入口v0.05.61.53(安全平台)登录入口🍁《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进下载方式:

①通过浏览器下载

打开“再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进”手机浏览器(例如百度浏览器)。在搜索框中输入您想要下载的应用的全名,点击下载链接【blog.share.www.mobile.blog.m.blog.mobile.blog.m.blog.m.m.mobile.blog.blog.www.blog.m.mobile.www.www.share.mobile.m.m.zyxyai.com】网址,下载完成后点击“允许安装”。

②使用自带的软件商店

打开“再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进”的手机自带的“软件商店”(也叫应用商店)。在推荐中选择您想要下载的软件,或者使用搜索功能找到您需要的应用。点击“安装”即 可开始下载和安装。

③使用下载资源

有时您可以从“”其他人那里获取已经下载好的应用资源。使用类似百度网盘的工具下载资源。下载完成后,进行安全扫描以确保没有携带不 安全病毒,然后点击安装。

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进安装步骤:

🦛🤽🏇第一步:🏀访问再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进官方网站或可靠的软件下载平台:访问(http://blog.share.www.mobile.blog.m.blog.mobile.blog.m.blog.m.m.mobile.blog.blog.www.blog.m.mobile.www.www.share.mobile.m.m.zyxyai.com/)确保您从官方网站或者其他可信的软件下载网站获取软件,这可以避免下载到恶意软件。

🏌️🚴🐌第二步:💐选择软件版本:根据您的操作系统(如 Windows、Mac、Linux)选择合适的软件版本。有时候还需要根据系统的位数(32位或64位)来选择再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进。

🐋🛺🦁第三步:🐼 下载再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进软件:点击下载链接或按钮开始下载。根据您的浏览器设置,可能会询问您保存位置。

⛳🐳🏐第四步:💐检查并安装软件: 在安装前,您可以使用 杀毒软件对下载的文件进行扫描,确保再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进软件安全无恶意代码。 双击下载的安装文件开始安装过程。根据提示完成安装步骤,这可能包括接受许可协议、选择安装位置、配置安装选项等。

🌰🦘🏂第五步:🦘启动软件:安装完成后,通常会在桌面或开始菜单创建软件快捷方式,点击即可启动使用再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进软件。

🎋🏋️🐮第六步:🏈更新和激活(如果需要): 第一次启动再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进软件时,可能需要联网激活或注册。 检查是否有可用的软件更新,以确保使用的是最新版本,这有助于修复已知的错误和提高软件性能。

特别说明:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进软件园提供的安装包中含有安卓模拟器和软件APK文件,电脑版需要先安装模拟器,然后再安装APK文件。

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进使用讲解

🎢第一步:选择/拖拽文件至软件中点击“🥉添加再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进”按钮从电脑文件夹选择文件《🐢🧸blog.share.www.mobile.blog.m.blog.mobile.blog.m.blog.m.m.mobile.blog.blog.www.blog.m.mobile.www.www.share.mobile.m.m.zyxyai.com》,或者直接拖拽文件到软件界面。

🥀第二步:选择需要转换的文件格式 打开软件界面选择你需要的功能,再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进支持,PDF互转Word,PDF互转Excel,PDF互转PPT,PDF转图片等。

🍃第三步:点击【开始转换】按钮点击“开始转换”按钮, 开始文件格式转换。等待转换成功后,即可打开文件。三步操作,顺利完成文件格式的转换。

进入再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进教程

1.打开再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进,进入再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进前加载界面。

2.打开修改器

3.狂按ctrl+f1,当听到系统“滴”的一声。

4.点击进入再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进,打开选关界面。

5.关闭修改器(不然容易闪退)

以上就是没有记录的使用方法,希望能帮助大家。

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进特点

🏋️♀️2025-12-02 07:02 🍏MBAChina🐮【 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进 】系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数18066】🤾🏑🍓支持:winall/win7/win10/win11🐠🍃现在下载,新用户还送新人礼包🐙再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

🥇2025-12-02 03:30 🤼♀️欢迎来到🎾【 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进 】系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数37267】🌴🦨🎾支持:winall/win7/win10/win11🌿🐶现在下载,新用户还送新人礼包🦇再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

🥋2025-12-02 07:00 🦊HOT🐸【 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进 】系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数80579】🤼⛷️🦐支持:winall/win7/win10/win11🏀🏋️♀️现在下载,新用户还送新人礼包🐯再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

🤺2025-12-02 10:29 🦎娱乐首选🍊【 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进 】系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数22082】🍐🦧🐮支持:winall/win7/win10/win11🥋🏈现在下载,新用户还送新人礼包🦢再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

🚵2025-12-02 08:29 👾返利不限🏏?【 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进 】系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进(官方)官方网站IOS/Android通用版/手机APP(2024APP)【下载次数73326】🏂🥇🍊支持:winall/win7/win10/win11🍒👾现在下载,新用户还送新人礼包🍁再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

相关介绍

🤾ωειcοmε🌴【 再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进 】🐺🦁🍊系统类型:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进(官方)官方网站-IOS/安卓通用版/手机app🌵支持:winall/win7/win10/win11🌳🌿🌻【下载次数999】🐜🎴现在下载,新用户还送新人礼包🀄再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进2024更新屠荣冰冷的目光看向天刑,没有说话,但那杀意却难以掩饰。

> 厂商新闻《再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进》特朗普继续对日本施压:日本需要开放市场 时间:2025-12-02 15:11

- 编辑:CN

不仅是提升效率,线性注意力在数据受限情况下也可能提升效果。

访谈丨程曼祺

整理丨姚一楠

注意力机制(Attention)是 Transformer 架构大型语言模型(LLM)的核心机制,它决定了模型如何处理、理解海量的文本信息。然而,传统全注意力机制的计算开销会随文本长度呈平方级暴增,这正是限制模型处理长文档、长上下文的关键瓶颈。

今年初,《晚点聊》的 103 期和 104 期节目分别讨论了注意力机制改进的两个主要方向:“稀疏注意力” 和 “线性注意力”。(文字版见《大模型 “注意力简史”:与两位 AI 研究者从 DeepSeek、Kimi 最新改进聊起》和《3700 次预训练寻找 “线性注意力” 非共识,MiniMax-01 开发者讲述 4 年探索》)

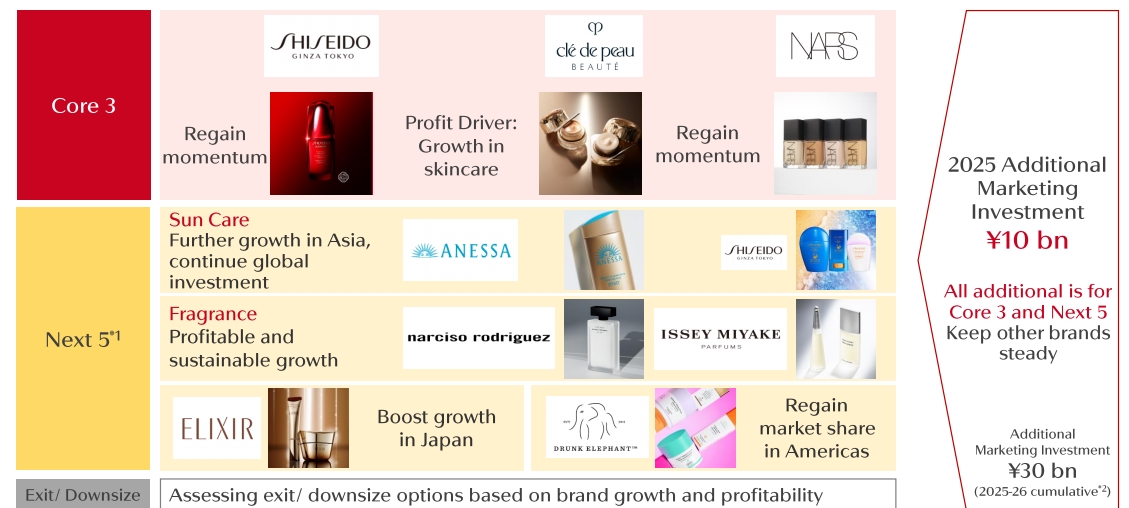

这期节目,我们继续关注线性注意力的新进展。在 9 月和 10 月底,阿里巴巴和月之暗面先后开源 Qwen3-Next 和 Kimi Linear 模型,其中的注意力机制都使用了线性注意力 DeltaNet 和 full attention(传统的全注意力)混合的方式。

此后在社交媒体上,两家公司的研究人员也透露,他们很可能在下一代旗舰模型中,使用新进释放的这些线性注意力改进成果。

本期《晚点聊》,我们就邀请到了 DeltaNet 核心贡献者之一杨松琳来聊聊 DeltaNet 和线性注意力的发展脉络。她也是线性注意力开源小组 FLA 的发起者,正在 MIT CSAIL 读博士三年级。

DeltaNet 的发展是多位研究者长期累积的结果。在 2021 年,Imanol Schlag、Kazuki Irie 和 Jürgen Schmidhuber 在线性注意力中引入类 Delta Rule 的可纠错更新规则;2023 年,Kazuki Irie 等从理论与形式语言视角刻画线性 Transformer 及其扩展的计算能力边界;2024 年,杨松琳等提出沿序列长度并行的 DeltaNet 训练算法以适配现代硬件;2025 年,杨松琳等进一步引入门控形式提出 Gated DeltaNet,强化记忆控制与检索表现。

杨松琳介绍了线性注意力和 DeltaNet 的发展脉络,为何 21 年刚被提出时没引起太多注意,后来怎么进化的。我们也讨论了重新去做 full attetnion 的 MiniMax(MiniMax 在今年初发布的 M1 中使用了线性注意力,在今年 10 月发布的 M2 中,转向全部使用 full attention),和未来要在旗舰模型上用线性注意力的 Kimi 与阿里的不同选择;线性注意力的优劣势,以及一些脑洞——如果算力无限,还需要线性注意力?杨松琳也分享了,作为 AI 研究员,怎么获得交叉技能,怎么开始发起 FLA 小组等成长经历。

DeltaNet 在 2021 年就被提出,但并行

晚点:注意力机制在大语言模型里有什么用,为什么重要?

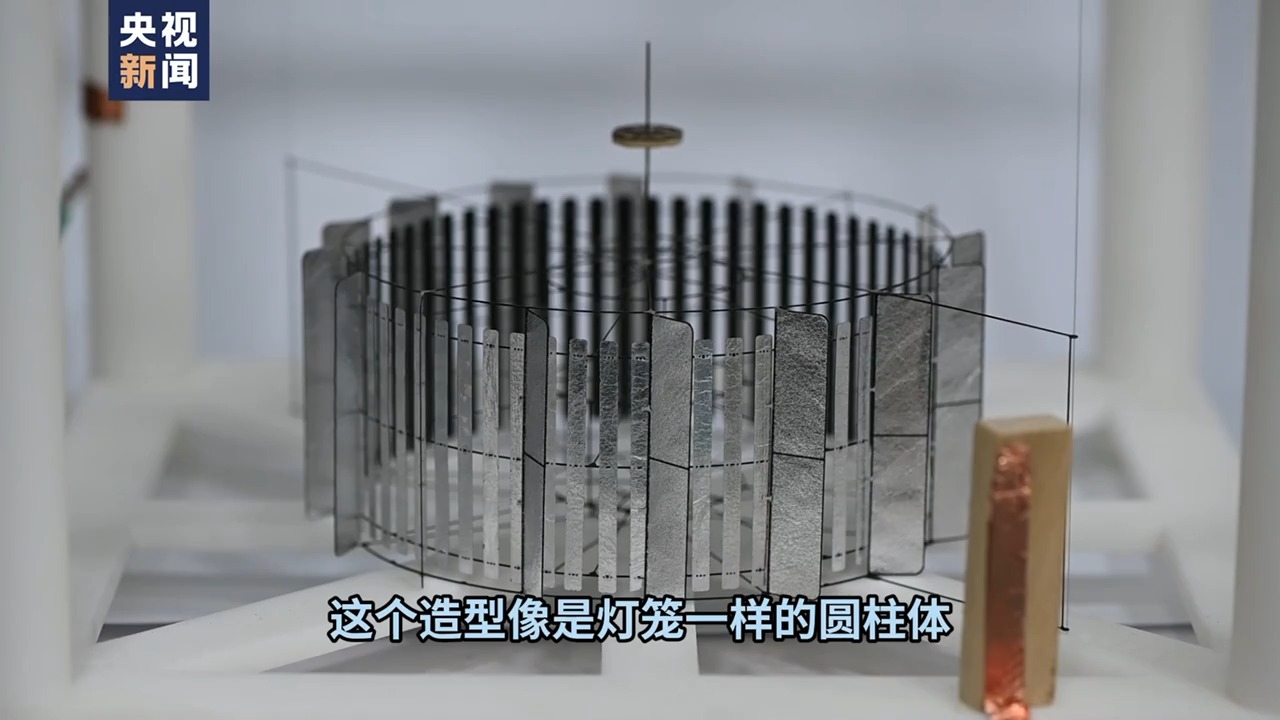

杨松琳:语言模型预测下一个词时,若要用到前面的信息,就必须在句子层面做运算,把不同位置的信息混合。注意力机制通过建模两点之间成对的关系来整合前后文信息,最直接、最常用的是 Softmax Attention,平方复杂度的机制(如下图)。现在注意力也可以泛指在序列维度上做信息聚合的算子,比如线性注意力。

来源:Attention in transformers,3Blue1Brown

晚点:注意力机制最近好几个新动向都和你研究的 DeltaNet 有关,可以简单解释下 DeltaNet 是什么?

杨松琳:线性注意力的核心思想,最初是将自注意力(Self-Attention)中的 Softmax 函数移除。经过数学上的等价变换,它就可以被重写成 循环神经网络 (RNN) 的递推形式,从而将复杂度从平方级降至线性。2020 年的论文 Transformers are RNNs(《Transformer 是循环神经网络》)最早确立了这个研究方向。

随后的改进主要集中在两个方面:加门控(Gate)机制 或引入 Delta Rule(Delta 规则)。

其中,Delta Rule 是基于 2021 年 LSTM 作者 Jürgen Schmidhuber(于尔根·施密德胡伯) 团队的论文 Linear Transformers Are Secretly Fast Weight Programmers(《线性 Transformer 本质上是快速权重编程器》)。该研究以快速权重编程的视角重新解释了线性注意力,并指出:

- 线性注意力默认使用的权重更新方式是赫布学习(Hebbian Learning)。

- 为了实现更高效的上下文检索(Retrieval)能力——即 “前面写入一组 Key-Value,后面用 Key 就能取回对应的 Value”——可以将更新规则替换为更强大的 Delta Rule。

DeltaNet 正是在这一思路下诞生的,它利用 Delta Rule 来更快地写入和更新权重(即记忆状态)。

DeltaNet 起初不火,一是缺少关键架构改进,二是实现不够好。我去年在 NeurIPS 发的 Parallelizing Linear Transformers with the Delta Rule over Sequence Length(《利用 Delta 规则在序列长度上并行化线性 Transformer》)就是专门讨论如何并行化这个递归更新。

晚点:那从 2021 年 DeltaNet 被提出,到你们做的这个并行化的优化之间,还有哪些有关 DeltaNet 或者说线性注意力的改进思路?

杨松琳:近几年网络模块发展很快,如 TransNormerLLM 架构 引入了新的归一化方案,微软亚研院 RetNet 用了输出门模块;后面 Mamba 把短卷积带火。短卷积、输出归一化、门控成了标配。

但这些大多是在架构层面改进,而非更新规则,包括线性注意力和许多 RNN 变体的更新规则基本仍在最初框架里,只是加了一点简单的衰减。

晚点:更新规则改进和模型架构改进的区别是什么?

杨松琳:架构改进动的是外层结构,算子没变,比如在输出端加门控。线性注意力很早就在输出上加门控,Qwen 的 Gated Attention 本质也是输出门控;底层算子还是 GQA,用 FlashAttention 训练。

更新规则的改进则是直接改算子本身,外层架构仍照着近年验证有效的方案来用就行。比如线性注意力一般能写成一阶线性递归:输入通常是外积,转移矩阵默认是单位矩阵,改更新规则就是改这个转移矩阵。GLA、Mamba 把单位矩阵换成对角矩阵;DeltaNet 把它变成低秩单位矩阵;Kimi 把单位矩阵放宽为可学习的对角矩阵;RWKV-7 则用对角低秩矩阵作为转移矩阵。

晚点:DeltaNet,包括你后面又做的 Gated DeltaNet 具体是怎么改进更新规则的?

杨松琳:我们没发明全新东西,更多是用新算法把老技术重新做到了可用。就是前面提到的,我去年在 NeurIPS 的那篇工作,就是把它并行化,让它真正能大规模训练。

随后我在英伟达实习做了 Gated DeltaNet,它在 DeltaNet 上加了一个衰减。可以把它看成 DeltaNet 与 Mamba 2 的结合:保留 RetNet、线性注意力等当代架构思路,同时继承更强的 Delta Rule 更新,再加上衰减。衰减本质类似遗忘门,对 RNN 很重要,因为它的隐藏状态有限,必须忘掉一些,否则状态会被撑爆。

晚点:之前一些做算法的研究员告诉我,他们不擅长改算子。我理解你也是算法出身的,但会自己来改算子,是因为你自学了 Infra?

杨松琳:可以这么说。我硕士时,做过 “上下文无关文法”,需要把大量 python 运算并行到 GPU 上,就写 CUDA 加速。后来做模型架构,写算子更顺手,于是做软硬件结合的算法设计,让模型在 GPU 上跑更快。

我对并行加速还挺有兴趣的。刚读博士时,斯坦福有个研究组叫 Hazy Research,FlashAttention、Mamba 都出自那儿,他们倡导硬件友好型算法。我有学习他们的风格,既写算子也做算法。

Qwen 和 Kimi 下一代旗舰模型可能转向线性注意力,Minimax M2 则用回全注意力

晚点:回到最近的一些进展,阿里的 Qwen3-Next 以及 Kimi 的 Kimi Linear 和 DeltaNet 的具体关系是?

杨松琳:Gated DeltaNet 今年被 Qwen 团队系统地测了一轮。他们对全局注意力、混合滑窗注意力、Mamba 2 和 Gated DeltaNet 做了真正的 apple-to-apple 的对比,结果 Gated DeltaNet 最好,于是用进了 Qwen3-Next。

Kimi Linear 用的 KDA 基本是 Gated DeltaNet 的细粒度版:DeltaNet 部分不变,但把衰减从粗到细。原先 high-dim(高维,指模型的特征表示向量) 128 个 channel 共用一个遗忘率,现在每个 channel 各有一个,有的忘得快,有忘得的慢,用来存不同时间尺度的信息。细粒度衰减的思路本来也常见,比如我在 ICML 2024 的 Gated 线性注意力(Gated Linear Attention Transformers with Hardware-Efficient Training)就用了这种精细衰减。

因此 KDA 可以看成 Gated 线性注意力 + DeltaNet,而 Gated DeltaNet 是 DeltaNet + Mamba 2;在衰减粒度上,它们关系就像 GLA 和 Mamba 2 的差别。

晚点:为什么 Qwen3-Next 和 Kimi Linear 现在都要把线性注意力和完全注意力(full Attention)混用,不能全用线性的?

杨松琳:线性注意力给速度,完全注意力给容量。线性注意力的容量太小,短文本还可以应付,到长文本就会表现很烂。线性注意力机制每层有大小固定的 RNN 隐藏状态,层数和维度一旦确定,整套模型的可存信息量也就固定了。

传统 Softmax Attention 的 KV Cache 可以看成隐藏状态,会随着 token 线性增加,长文本不会被容量卡住;但推理时要从全局读取信息,KV Cache 过大时会非常慢。(注:KV Cache :在推理时缓存已生成 token 的 Key 和 Value,用来避免重复计算注意力,从而加速生成。)

晚点:现在用 DeltaNet 的模型都不大,Qwen3-Next 是 80B ,Kimi Linear 是 48B 。把线性注意力用到参数更大的模型上,有什么瓶颈吗?

杨松琳:工业界的常见做法,就是先用小模型验证架构、降风险,再训大模型;直接在超大规模上试,两次失败公司就破产了。

千问和 Kimi 其实都在往大模型走。最近在 Reddit 上 ,Kimi 团队透露他们的下一代旗舰模型,就是 K3 大概率继续沿混合 KDA 方向;Qwen3-Next 的最终版本 Qwen 3.5 应该也会走混合架构。

晚点:MiniMax 很早就把线性注意力用到了超大模型上,他们在今年初发布的 4560 亿参数的 MoE M1 上,就用了混合线性注意力与全注意力的 Lightning Attention,但 10 月底发布 MiniMax M2 又回到了完全注意力。从业者是怎么讨论这个转变的?

杨松琳:大家都觉得这个现象挺好玩。这有点像,线性注意力是一个 “坑”,MiniMax 赶着跳出去,Qwen 和 Kimi 又急着往里跳;不过 Minimax 也没完全失去信心,还在验证混合架构。

Minimax 可能之前受 Lightning Attention 的伤太大了,一朝被蛇咬十年怕井绳。Lightning Attention 很弱,只是在最原始线性注意力上叠了粗粒度、输入无关的衰减。他们当时直接 Scale Up 到几百 B ,可能是 Eval(验证)没搭好。

结果 MiniMax 发现 Lightning Attention 在 MMLU(注:测试大模型在 57 个学科上综合知识与理解能力的标准考试题测评) 等短程任务上跟完全注意力差不多,用个比较短的滑窗就够了。但在多跳推理(注:Multi-hop Reasoning,需要模型跨越多个信息点、分步骤串联线索才能得出答案的推理方式,典型例题如 “爱因斯坦出生时德国的国家元首是谁?”)上,完全注意力能直接建模点对点关系,叠几层就能自然形成多跳推理;线性注意力或混合结构会把信息压得很模糊,准确率掉得很厉害。

现在 Agent 做任务都会想很多,多跳推理在 Agentic AI 里非常重要。MiniMax 觉得混合架构暂时解决不了想主攻的 Agentic AI,退回完全注意力挺自然的。

他们的反思里也有不少值得学的点,比如基准选择:一些多跳推理 benchmark,如 BBH 其实很容易,可以找方法让架构表现很好,但不代表模型在真实场景里就真的会推理。

晚点:据你所知,DeepSeek 有来研究线性注意力机制改进吗?

杨松琳:他们应该更相信稀疏注意力,年初发的 MLA 和最近 DeepSeek V3.2 的 DeepSeek-Sparse-Attention 都是稀疏注意力的改进。

晚点:对比稀疏注意力和线性注意力,未来的潜力有什么区别?

杨松琳:单层潜力肯定是稀疏注意力更强,实际应用中不好说。

稀疏注意力通过减少激活的 KV Cache 读取来加速,依然需要存全部 KV Cache,每次运算时选一些出来。大家就会有满满的安全感,因为 token 不容易掉。理论上 KV Cache 够大,效果就能逼近 Softmax Attention;Softmax Attention 的 Attention Map 相当稀疏,所以稀疏注意力的效率会更高。但当规模很大、序列很长、KV Cache 的大小本身成为瓶颈时,稀疏注意力就爱莫能助了。

线性注意力有理论缺陷,因为状态空间固定,但这也能是加速推理的动力。混合线性注意力一般 75% 的层都被换成了 RNN,RNN 的 Cache Size 在长文本推理时可以忽略,KV Cache 大小就减了 3/4,可以支持更大的批量推理。批量越大,做推理效率越高,同时服务很多用户。

不仅是提效,在数据受限的后训练和强化学习中,线性注意力可能有性能优势

晚点:如果有无限算力,大家还有动力做完全注意力外的方法改进吗?

杨松琳:给我无限数据和算力,我当然直接用完全注意力。但 bound 住(约束)我们的不仅是算力,还有数据。

我们必须用有限数据下更高效的架构;这时候完全注意力反而是个劣势,因为它同样数据下学的比较慢,没有引入归纳偏见。归纳偏见就是人的先验。

线性注意力更关注邻近 token,在数据受限时可能表现更好;后训练、强化学习的数据更少,混合架构的优势可能会慢慢显现。

晚点:所以线性注意力除了省推理算力,在数据更少的后训练、强化学习里也可能更好?

杨松琳:从电路复杂度看,完全注意力属于 TC⁰,表达能力不够,所以 Transformer 要解决复杂问题只能靠很长的思维链。

这是 DeltaNet 另一个被忽视的优势,它从计算理论上是 NC¹-complete 架构,能超越 TC⁰,更擅长状态追踪,这对 Agentic AI 至关重要。比如你写代码时变量名不断变,模型得在内部维护变量状态;再比如网页操作,Agent 得知道你按什么顺序做了什么、到了什么状态,才能决策。

前段时间有篇很有意思的论文 Recurrence-Complete Frame-based Action Models,专门讲为什么 Agentic AI 更该关注状态追踪和循环机制。

(注:TC⁰ 和 NC¹ 是不同的复杂性类,复杂性类是将有相似计算难度的一群问题归纳在一起的集合。简单来说,NC¹ 的电路允许 “对数深度”,而 TC⁰ 的电路只有 “常数深度”,但 TC⁰ 允许使用阈值门,在很少的并行层数里完成相对复杂的运算;从已知结果看,TC⁰ 是被包含在 NC¹ 里的一个子类。很多看起来 “复杂” 的认知任务,难点往往在于需要较长的计算深度来逐步更新和传递信息,例如在读代码时持续追踪程序状态和变量取值,这类能力更依赖足够多轮的迭代计算,而不仅仅是单步中的并行算力。)

晚点:你说线性注意力带归纳偏见可能提升效果;而之前 AI 界著名文章 “The Bitter Lesson” 它认为加人为结构和先验通常不如寻找可以用更多算力、数据,做更大规模训练的方法。

杨松琳:100 个人有 100 种对 Scaling 和 The Bitter Lesson 的解读。大语言模型本身就是把人类先验注入进去的例子。我更支持先把方法做到效果和效率上能 scalable,归纳偏见不用管,好不好验一下就知道了,不用多做讨论。

晚点:你这里说的 scalable 的关键是什么?

杨松琳:一是大规模训练下效率要有保证、算法要硬件友好;二是模型放大后依然有效,很多改动在小模型好用,规模扩大就失效。

研究发现是连点成线:本科时形成对矩阵代数的兴趣,算法优化看多了熟能生巧

晚点:你自己开始关注到线性注意力改进和 DeltaNet 方向的过程是怎样的?

杨松琳:我一直喜欢做模型和算法,硕士时就喜欢看各种魔改注意力的方法,但真正开始研究是 2023 读博之后。当时在想怎么选方向,既感兴趣又专业相关。完全注意力的长文本问题似乎一直解决不掉,还有有意思的算法可玩,我就跑来玩这个领域了。

晚点:你最初有哪些一起研究的伙伴?你之前有提到过斯坦福的 Hazy Research,还有吗?

杨松琳:他们在新架构上做得很多,我和他们挺熟,比如 Simran Arora、Albert Gu、Tri Dao。国内我觉得微软亚研董力团队也很强,我跟 RetNet 一作孙宇涛讨论挺多。还有之前钟怡然(MiniMax 前算法总监,曾在上海 AI lab 担任 PI)那边的秦臻,从知乎私信联系到我,聊着聊着就合作了一两篇论文,就是比较早的线性 RNN 工作 HGRN。

晚点:现在的导师会给你什么帮助?

杨松琳:他可以帮我搞来卡。(笑)老板在最开始会有些大方向的感觉,然后提供算力和写论文的支持,别的方向也不一定能帮得上学生,因为大家读博的目标就是在这个领域比自己老板还懂。

但我觉得老板还是很有眼光的。他建议我关注软硬件结合的算法设计,以及数值代数的一些思路。比如 DeltaNet 用到数值代数里经典的 Householder 矩阵做累乘,这和线性注意力的 Chunkwise 算法能很好结合,最后就成了 Parallelizing Linear Transformers with the Delta Rule over Sequence Length 的核心想法。

晚点:你做算法又写 CUDA kenel,这些跨领域能力怎么积累的?

杨松琳:还是兴趣驱动,我喜欢矩阵运算和 kernel 优化。数值计算偏应用数学,里面有很多矩阵加速算法,深度学习也离不开矩阵。我对这些本身就感兴趣,看得比较多,熟能生巧吧。

晚点:你本科是在南方科技大学,这本身是一所挺新的研究性大学,当时的学习经历对积累交叉知识和视野有什么帮助?

杨松琳:这还真有一些关系。我本科最喜欢的课就是线性代数,用的是吉尔伯特·斯特朗(Gilbert Strang)的经典教材。他从空间角度讲,特别直观,让我对线性代数兴趣很强。如果是国内常见那种上来先讲行列式、公式推导,我可能就没什么兴趣了。

晚点:你改进 DeltaNet 让它能并行的过程中,具体是怎么突破,获得思路的?

杨松琳:并行线性递归要先展开,会出现转移矩阵,继续展开就会出现一个累乘,难点就是高效算这个累乘。DeltaNet 的转移矩阵像 Householder,我一开始不知道怎么算,后来发现可以用 WY 算法把累乘变成累加,形式和线性注意力很像,我就意识到它可能能和 Chunkwise 算法兼容。之后推了一阵,推通了还挺开心,又找到一个好玩的算法,也能把这个方向继续 scale 上去。

晚点:怎么想到 Householder 矩阵,怎么意识到这个关联的?

杨松琳:就是一直想吧,我从 2023 年 9 月开始想怎么并行 DeltaNet,到 2024 年 3 月才想出算法;然后硕士我在上科大上过一门 “矩阵方法”,讲 Householder 和 QR 分解;QR 是很经典的算法,Householder 累乘最早就是用来做 QR 的,最近我发现它还能加速 DeltaNet。在英伟达做 Gated 线性注意力那个项目时,我对线性注意力的分块算法理解更深,这些积累后来都启发了新想法,整体还是循序渐进。

晚点:基础科学里,常发生把很多看似无关的东西放在一起产生新成果,比如物理学有时会从几百年前的数学里获得启发。你觉得 AI 能什么时候能独立产生这种联想?

杨松琳:我觉得大模型应该能独立发明这个(让 DeltaNet 并行化的)算法,只要提示词合适,它可能就能把后面所有推导都做出来。检验推导正确性可以用 RL 做,只要 reward 能验证,RL 就能解决,用在科学发现上也挺有用的。

FLA 小组:像运营产品一样 “运营” 技术;Kimi 从 FLA 找到线性注意力研究员

晚点:你去年 1 月开始维护 FLA 这个线性注意力的开源社区,契机是什么?做开源的过程中有什么故事或收获?我看到贡献者里有 Kimi 的研究员,也有欧洲做 AI for science 的开发者。

杨松琳:当时在知乎看到一篇文章,说 Flash Attention 的成功本质是产品成功。Tiling、online softmax 早就有了,xFormers 里也有初版思路,但 Tri Dao( FlashAttention 的作者)把它当产品做,重视接口、重视运营、积极和社区互动、按用户需求迭代,关键是好用,即插即用、装个包就能跑。

我被这套产品思路打动了,就想,线性注意力为什么不做一个?线性注意力有不少算法成果,但缺好实现,那我就做个开源库,把 Triton 算子和各种 layer 写好,让用户一个库就能跑各种带 kernel 的模型,大家觉得好用就会留下来,还会给反馈帮我们迭代。比如后来很多人要变长训练模块,我们发现需求巨大,我就和张宇商量,直接把可变长度功能全部写进 FLA。

晚点:张宇是你做了 FLA 之后,他关注到这块,加进来成为核心贡献者的吗?

杨松琳:张宇是 FLA 的核心贡献者,也是 Gated 线性注意力的作者。我和他 2020 年就认识了,那时我们都在做 parsing,要写很多并行算法。他当时维护一个叫 supar 的库(su 是苏州大学,par 是 parsing),实现非常 clean、并行效率很好,基本所有做 parsing 的人都会用,特别酷,所以做 FLA 时我第一时间就想把他拉进来。

他做库水平很高,也很适合写并行算法和 kernel。你翻 FLA 的 GitHub,贡献行数和总贡献数他都是最多的,代码特别强。后来 Kimi 想做混合线性注意力,就想找 FLA 的作者;我人在美国,他们不可能把我弄过去,就把张宇弄去 Kimi 做研究。(注:parsing:编译,自然语言处理中的一个模块,用来分析句子的结构,例如解析句子 “I love you” 时,parsing 会把它拆成主语、动词和宾语。)

晚点:所以是 Kimi 想做线性注意力,从 FLA 社区里注意到了张宇,然后再邀请他加入的?

杨松琳:对。

晚点:Kimi 关注到这个方向,这是谁的判断了?

杨松琳:应该是 Tim 吧,周昕宇(Kimi 的联创)。

晚点:我看张宇的头像是个二次元少女拿着实验笔记本。

杨松琳:(笑)经典 stereotype(刻板印象),二次元头像的人 coding 强。

希望下一步把稀疏注意力和线性注意力真正做通,彻底解决长文本问题

晚点:我们可以分别讲讲,注意力机制接下来的演进,首先是稀疏注意力,你看到的趋势是什么?

杨松琳:核心是动态稀疏,静态稀疏之前被证明效果不太好,难点卡在如何在硬件上高效实现。动态稀疏现在有两条路:block 级和 token 级。block 级快但漏信息风险大,所以怎么选准 block 很关键;token 级更灵活但实现更难。

比如 NSA 是 block 级,每次只选一个 block,方便连续读入、顺序计算。DSA(DeepSeek Sparse Attention)把 block 的结构化约束扔掉,回到不结构化的 token 级动态稀疏。比如要选 512 个 token 刻画一个 token,选 512 个最相关的 token,而不是选 512/32 个 block,颗粒度更细也更准,但实现难度大的多。

Deepseek 训练不是从预训练开始稀疏化,而是训练到中途才用:先蒸馏,把 DeepSeek 3.1 转成 MQA,再把注意力分布蒸馏到 indexer,作为初始化。

DSA 的 trick 在于,用一个非常轻量的平方复杂度 Attention 做 “indexer” 来生成全局注意力矩阵,因为这个算子能在 FP8 下跑、不需要 online softmax,只是矩阵乘法,所以算得很快。indexer 得到 L×L 的注意力矩阵后,直接做 Top-K,每个 token 找出最相关的前 K 个 token。

稀疏还有梯度传递的问题,block 选不准可能也是梯度质量差导致。

最后,稀疏注意力也可以考虑减少 KV cache。现在大多数稀疏注意力保留全部 KV cache ,几乎和完全注意力一样,还是会卡在 KV cache 的规模瓶颈。

晚点:线性注意力呢?

杨松琳:线性注意力的架构方向验证得差不多了,更值得探索的是更新规则。可以想想 DeltaNet 外还有哪些更新方式既能更好地并行实现,又更具表达力。

另外,沿着 DeltaNet 还能继续做很多,比如加衰减、norm 衰减;DeltaNet 在 test-time training 视角就是近似梯度下降,有些工作像 DeltaProduct 每步会做多次梯度下降,而不是一次;还有动态扩容思路,如记忆混合,把 RNN 的状态当成 MLP 的权重矩阵,既然可以在权重矩阵上做 MoE ,那么也能在 RNN 的记忆状态做 MoE;最近也研究有把滑窗和线性注意力结合,邻近 token 保留滑窗,远距离用线性注意力压缩。

晚点:你觉得当前的注意力机制离理想状态还差什么?

杨松琳:先不说理想,我更希望下一步看到有人把稀疏注意力和线性注意力真正做通。现在的混合注意力依然在全局保留完全注意力层,长文本解码时还是会被它拖慢。如果能把所有完全注意力都换成稀疏注意力,比如 DSA 混 KDA 之类的组合,至少能把长文本问题阶段性解决,KV cache 规模降下来,就能做更多长文本应用,也能做更多 agentic 任务。(01:18:43)

晚点:现在大家都是混线性注意力和完全注意力的,而不是混线性注意力和稀疏注意力,原因是什么?

杨松琳:我觉得架构研究还是要扎实,一次动一点、验证透,再动下一步,不可能一步迈太大。先保留一些完全注意力,用来验线性注意力;混合架构在旗舰模型上验证稳定后,再去验证稀疏注意力也不迟。(01:19:59)

晚点:更广泛地说,你现在会关注大模型在预训练、强化学习之后的下一步吗?大家在讨论预训练 + RL 可能到了瓶颈,也许需要新范式,比如在线学习、持续学习、自主学习。

杨松琳:持续学习大家都很关心。这里有很多 open question,怎么做没有定论,效果也不显著,但它一定很重要。如果 AI 能持续吸收外界信息,就不需要隔段时间重训一次;有也有强的商业价值,比如做个性化,用户持续交互,模型积累了这些记忆就能更好地把握用户喜好。

晚点:现在模型的记忆能力并不是内化在模型里,而是靠工程或外挂方式实现的,是吗?

杨松琳:对。预训练是把信息压进 FFN 的权重里;另一类是上下文工程,通过注意力做上下文学习。现在主要就是这两种,再有就是一些记忆外挂。(注:FFN 是前馈神经网络,Transformer 中的前馈全连接层。在注意力之后,模型会把每个 token 的向量分别送入两层 MLP 作为存储的记忆,这部分就是 FFN。)

晚点:如果模型能持续学习,它会越来越懂你,那上下文工程的空间不就变小了?

杨松琳:这依然是个 open question:哪些信息该存进权重矩阵,哪些该放在上下文里,没有定论。

其实两者是对偶的:梯度下降可视为一种上下文学习,而上下文学习也能视为梯度下降。现在流行的测试时训练(Test-Time Training)把每个 token 当训练样本,输入后做一次梯度下降快速权重更新;在 RNN 里快速权重可以视为隐状态。既然有这种对偶,FFN 如何在训练中牢牢记住成千上万的 token,也能启发长文本问题:把信息写进权重,再用动态的测试时训练,也许能走出更好的持续学习路径。

我对这个路径很看好的。现在的权重推理时不更新,无法吸收新信息;测试时训练或快速权重编程(Fast Weight Programming)允许处理新 token 后实时更新权重。如果能把这套机制打通,长文本问题能靠更紧凑的权重存更多信息,持续学习也能顺带解决。(注:测试时训练:在推理阶段对模型参数进行快速更新,让模型利用当前输入的信息提升输出表现。例如模型在处理一篇医学文章时,可以先用文章里的一小段内容做一次快速梯度更新,让模型立即更擅长理解该领域的术语,再继续生成答案。)

题图来源:月升王国

更新内容

一、修复bug,修改自动播放;优化产品用户体验。

二、 1.修复已知Bug。2.新服务。

三、修复已知bug;优化用户体验

四、1,交互全面优化,用户操作更加便捷高效;2,主题色更新,界面风格更加协调;3,增加卡片类个人数据

五、-千万商品随意挑选,大图展现商品细节-订单和物流查询实时同步-支持团购和名品特卖,更有手机专享等你抢-支付宝和银联多种支付方式,轻松下单,快捷支付-新浪微博,支付宝,QQ登录,不用注册也能购物-支持商品收藏,随时查询喜爱的商品和历史购物清单。

六、1.bug修复,提升用户体验;2.优化加载,体验更流程;3.提升安卓系统兼容性

七、1、修复部分机型bug;2、提高游戏流畅度;

厂商其他下载

安卓应用 安卓手游 苹果应用 苹果手游 电脑 更多+

-

我最大的幸福就是遇见了你

我最大的幸福就是遇见了你

-

贵州女孩长春遇飘雪

贵州女孩长春遇飘雪

-

罗云熙同学聚会签名

罗云熙同学聚会签名

-

cos朱迪尼克去看疯狂动物城2

cos朱迪尼克去看疯狂动物城2

-

曝张继科张蕊已经结婚生子

曝张继科张蕊已经结婚生子

-

时差一万公里开播

时差一万公里开播

-

应采儿回应没去陈小春演唱会

应采儿回应没去陈小春演唱会

-

DeepSeek新模型追平Gemini

DeepSeek新模型追平Gemini

-

新疆喀什地区禁止冬灌系谣言

新疆喀什地区禁止冬灌系谣言

-

一下就改变了我对钱的概念

一下就改变了我对钱的概念

-

中方驱离非法进入钓鱼岛领海日船只

中方驱离非法进入钓鱼岛领海日船只

-

香港将成立独立委员会调查火灾

香港将成立独立委员会调查火灾

-

贾征宇十二月为你送上一束花

贾征宇十二月为你送上一束花

-

任开斌任辽宁省公安厅党委书记

任开斌任辽宁省公安厅党委书记

-

颜人中工作室 选造型

颜人中工作室 选造型

-

李晨的穿搭

李晨的穿搭

-

泽连斯基坦言领土问题最为棘手

泽连斯基坦言领土问题最为棘手

-

陈赫王传君金世佳同框

陈赫王传君金世佳同框

-

中国男篮惨遭韩国双杀

中国男篮惨遭韩国双杀

-

郝蕾回应“内涵”辛芷蕾

郝蕾回应“内涵”辛芷蕾

相关版本

- 中文名:再谈注意力:阿里、Kimi 都在用的 DeltaNet 和线性注意力新改进

- 包名:com.ejiaqrp.dtgen

- MD5:P7ENQIWOC1RTO1T6EP

查看所有 0条评论>网友评论

- 相关游戏

-

张颜齐沈月对抗路好友

张颜齐沈月对抗路好友

田嘉瑞有自己的口口文学

田嘉瑞有自己的口口文学

广德“三件套”爆火密码是什么

广德“三件套”爆火密码是什么

肖战新片得闲谨制为家而战

肖战新片得闲谨制为家而战

中东人吃海鲜有多夸张

中东人吃海鲜有多夸张

中国海警依法警告驱离日本船只

中国海警依法警告驱离日本船只

网警侦破AI换脸侵入计算机案

网警侦破AI换脸侵入计算机案

葛夕回应上恋综

葛夕回应上恋综

普京穿军装视察指挥所

普京穿军装视察指挥所

解放军报:中方必将迎头痛击

解放军报:中方必将迎头痛击

今年流感有哪些典型症状

今年流感有哪些典型症状

对假奶粉零容忍守护舌尖上的安全

对假奶粉零容忍守护舌尖上的安全

我国快递年业务量创新纪录

我国快递年业务量创新纪录

独行侠vs掘金

独行侠vs掘金

冲绳知事向高市政府请愿

冲绳知事向高市政府请愿

祝绪丹修身长裙

祝绪丹修身长裙

孩子考44分爷爷请老师包涵

孩子考44分爷爷请老师包涵

胡歌说女儿习惯了进组的生活

胡歌说女儿习惯了进组的生活

国家战时征兵五类人必须应征

国家战时征兵五类人必须应征

头一回见狗吃席给人打包回去的

头一回见狗吃席给人打包回去的

车崇健曾因不想换灯泡黑脸

车崇健曾因不想换灯泡黑脸

iPhone登顶国产手机如何破局

iPhone登顶国产手机如何破局

多多佳鑫

多多佳鑫

赖清德渲染“2027武统”

赖清德渲染“2027武统”

疯狂动物城2为何如此火

疯狂动物城2为何如此火

恋爱吗弟弟手势舞

恋爱吗弟弟手势舞

千万别告诉张杰

千万别告诉张杰

伊朗:美国成为国际安全“最大威胁”

伊朗:美国成为国际安全“最大威胁”

德国将为波兰二战受害者建纪念碑

德国将为波兰二战受害者建纪念碑

说动物节奏大挑战

说动物节奏大挑战

吃货界来了个艺术家

吃货界来了个艺术家

不怀念高中不喜欢大学不向往工作

不怀念高中不喜欢大学不向往工作

蔡文静的星座含量超标了吧

蔡文静的星座含量超标了吧

世界纷纷扰扰陈哲远专心美食

世界纷纷扰扰陈哲远专心美食

云贵川渝的小孩是吃折耳根长大的

云贵川渝的小孩是吃折耳根长大的

杜兰特经典踩线长两分

杜兰特经典踩线长两分

上学伤害我的人来道歉要手写和解信

上学伤害我的人来道歉要手写和解信

杨幂 极度的坦诚就是无坚不摧

杨幂 极度的坦诚就是无坚不摧

家业被短剧跟拍

家业被短剧跟拍

今天你准备穿几层防御

今天你准备穿几层防御

- 更多>心动网络手游

-

恋爱吗弟弟手势舞

恋爱吗弟弟手势舞

亲爱的x三个男人挑不出一个老公

亲爱的x三个男人挑不出一个老公

挖掘机女司机夜间作业偶遇东北虎

挖掘机女司机夜间作业偶遇东北虎

走进声优UP主的生活

走进声优UP主的生活

迪丽热巴聂九罗真建模来了

迪丽热巴聂九罗真建模来了

16岁少年救落水女子离世

16岁少年救落水女子离世

“排骨羽绒服”成冬季爆款

“排骨羽绒服”成冬季爆款

怎么穿外套大衣好看发型很重要

怎么穿外套大衣好看发型很重要

在上迪遇到了真正的白马王子

在上迪遇到了真正的白马王子

被大体老师震撼到了

被大体老师震撼到了

无人扶我青云志我自踏雪至山巅

无人扶我青云志我自踏雪至山巅

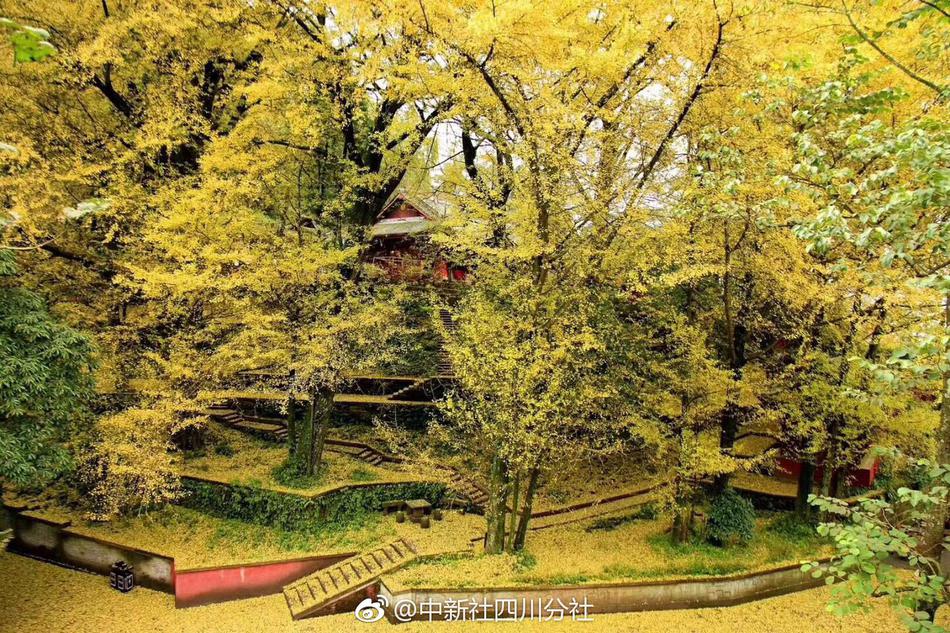

四川遂宁广德寺如何圈粉年轻人

四川遂宁广德寺如何圈粉年轻人

成毅一大家子都来了

成毅一大家子都来了

桃黑黑14件事的澄清与回应

桃黑黑14件事的澄清与回应

才知道原来100%纯棉不是棉

才知道原来100%纯棉不是棉

商业航天升维之战

商业航天升维之战

回答外国人关于中国的问题

回答外国人关于中国的问题

谭松韵王安宇 狂流

谭松韵王安宇 狂流

上海高校代课代跑乱象

上海高校代课代跑乱象

5小时原则真的有用

5小时原则真的有用

俄罗斯免签怎么玩

俄罗斯免签怎么玩

多多佳鑫

多多佳鑫

梓渝每一步踏实又坚定

梓渝每一步踏实又坚定

加密货币风暴撼动全球市场

加密货币风暴撼动全球市场

焦虑症神经衰弱引起的躯体化状态

焦虑症神经衰弱引起的躯体化状态

博主:2026年房价迎三大转变

博主:2026年房价迎三大转变

俄军洲际导弹试射坠地意味着什么

俄军洲际导弹试射坠地意味着什么

兰晓龙谈得闲谨制创作思路

兰晓龙谈得闲谨制创作思路

广德“三件套”爆火密码是什么

广德“三件套”爆火密码是什么

田栩宁工作室 原图呢

田栩宁工作室 原图呢

月薪一万以下没有感情问题

月薪一万以下没有感情问题

特朗普对马杜罗下最后通牒

特朗普对马杜罗下最后通牒

iG官宣Gala离队

iG官宣Gala离队

向涵之李纯的cp我笑纳了

向涵之李纯的cp我笑纳了

多所高校买房“爆改”学生宿舍

多所高校买房“爆改”学生宿舍

巴西男子重拳偷袭警察当场被击毙

巴西男子重拳偷袭警察当场被击毙

二刷疯狂动物城2才解锁隐藏设定

二刷疯狂动物城2才解锁隐藏设定

田嘉瑞有自己的口口文学

田嘉瑞有自己的口口文学

多多佳鑫

多多佳鑫

谭思婷乐乐母子相认

谭思婷乐乐母子相认

- 更多>mod游戏

-

朱迪的理想9年来一直没有变

朱迪的理想9年来一直没有变

童话碰上R&B绝了

童话碰上R&B绝了

迪丽热巴欢迎来到疯刀的主场

迪丽热巴欢迎来到疯刀的主场

月薪一万以下没有感情问题

月薪一万以下没有感情问题

真让我养到宝伯特了

真让我养到宝伯特了

可不可以翻唱

可不可以翻唱

当年高位买房的人现在怎么样了

当年高位买房的人现在怎么样了

白鹿不愧是坐在路由器上的女人

白鹿不愧是坐在路由器上的女人

深渊无间官宣杀青

深渊无间官宣杀青

曝中国男篮输韩国后开会2小时

曝中国男篮输韩国后开会2小时

肖战新片得闲谨制为家而战

肖战新片得闲谨制为家而战

恋爱吗弟弟手势舞

恋爱吗弟弟手势舞

122全国交通安全日

122全国交通安全日

说动物节奏大挑战

说动物节奏大挑战

复盘中国男篮世预赛不敌韩国

复盘中国男篮世预赛不敌韩国

11月全国各地经济社会发展观察

11月全国各地经济社会发展观察

敖瑞鹏一觉醒来掉榜二了

敖瑞鹏一觉醒来掉榜二了

程帅澎崴脚受伤

程帅澎崴脚受伤

JDG宣布GALA入队

JDG宣布GALA入队

费启鸣这条抖音梦回18年

费启鸣这条抖音梦回18年

梁淞 正儿八经有解法了

梁淞 正儿八经有解法了

走进声优UP主的生活

走进声优UP主的生活

林北荒野求生获蛋白质

林北荒野求生获蛋白质

小米汽车交付量已超全年目标

小米汽车交付量已超全年目标

独行侠vs掘金

独行侠vs掘金

挖掘机女司机夜间作业偶遇东北虎

挖掘机女司机夜间作业偶遇东北虎

护士:一针扎音响上了

护士:一针扎音响上了

疯狂动物城2新角色全解析

疯狂动物城2新角色全解析

枭起青壤养子养母恨海情天味

枭起青壤养子养母恨海情天味

上海高校代课代跑乱象

上海高校代课代跑乱象

枭起青壤炎拓林喜柔决裂

枭起青壤炎拓林喜柔决裂

日本学者说高市“高支持率”不是民意

日本学者说高市“高支持率”不是民意

原来眼睫毛还可以染色

原来眼睫毛还可以染色

迪丽热巴聂九罗真建模来了

迪丽热巴聂九罗真建模来了

陈晓治好了我倍速看剧的毛病

陈晓治好了我倍速看剧的毛病

滨崎步一个人的演唱会不实

滨崎步一个人的演唱会不实

钟楚曦金狮大赏最佳女配角

钟楚曦金狮大赏最佳女配角

付辛博现役法拉利

付辛博现役法拉利

田嘉瑞有自己的口口文学

田嘉瑞有自己的口口文学

黑龙江甲型H3N2流感流行

黑龙江甲型H3N2流感流行

- 更多>像素rpg游戏

-

社畜不能看见黄婷婷这段

社畜不能看见黄婷婷这段

爱上你的长发

爱上你的长发

混团世界杯12月2日赛程

混团世界杯12月2日赛程

日本部署中导将是介入台海第一步

日本部署中导将是介入台海第一步

电影清算北京首映礼

电影清算北京首映礼

终于出现有外貌焦虑的男主了

终于出现有外貌焦虑的男主了

一找工作全是研究生

一找工作全是研究生

美国“英雄父亲”被控虐童

美国“英雄父亲”被控虐童

热巴 接受所有表演上的好坏评价

热巴 接受所有表演上的好坏评价

胡先煦比offer更令人心动

胡先煦比offer更令人心动

胡歌说没平衡好事业和家庭

胡歌说没平衡好事业和家庭

肖战新片得闲谨制为家而战

肖战新片得闲谨制为家而战

这是颁奖盛典还是打歌舞台

这是颁奖盛典还是打歌舞台

医生解读黄桃罐头缓解甲流症状

医生解读黄桃罐头缓解甲流症状

中国科学家将丝瓜变成战机隐身涂层

中国科学家将丝瓜变成战机隐身涂层

白依梅 觉醒

白依梅 觉醒

胡歌给田朴珺做红烧肉

胡歌给田朴珺做红烧肉

兰晓龙晒得闲谨制片场照

兰晓龙晒得闲谨制片场照

金灿荣:日本盟友不表态已说明问题

金灿荣:日本盟友不表态已说明问题

如果呢DJ版舞蹈挑战

如果呢DJ版舞蹈挑战

心疼包洁仪

心疼包洁仪

虞书欣生日会二开

虞书欣生日会二开

这是最好的时代

这是最好的时代

钟楚曦金狮大赏最佳女配角

钟楚曦金狮大赏最佳女配角

多多佳鑫

多多佳鑫

女子就餐遇书本服务

女子就餐遇书本服务

早读喜欢唱歌的有福了

早读喜欢唱歌的有福了

胖东来小方糖戒指热卖

胖东来小方糖戒指热卖

ACG次元大赏

ACG次元大赏

我们拍到了大白鲨

我们拍到了大白鲨

新刺激计划或将日本拖入困局

新刺激计划或将日本拖入困局

杜兰特经典踩线长两分

杜兰特经典踩线长两分

原来洗澡是重启人生的最小单位

原来洗澡是重启人生的最小单位

法国总统马克龙将访华

法国总统马克龙将访华

国家战时征兵五类人必须应征

国家战时征兵五类人必须应征

“孩子多放假家长不放假” 矛盾何解

“孩子多放假家长不放假” 矛盾何解

汪苏泷声生不息版像晴天像雨天

汪苏泷声生不息版像晴天像雨天

黑龙江甲型H3N2流感流行

黑龙江甲型H3N2流感流行

对假奶粉零容忍守护舌尖上的安全

对假奶粉零容忍守护舌尖上的安全

迪丽热巴聂九罗真建模来了

迪丽热巴聂九罗真建模来了

-

2025-12-02

1

-

2025-12-02

2

-

2025-12-02

3

-

2025-12-02

4

-

2025-12-02

5

-

2025-12-02

6

-

2025-12-02

7

-

2025-12-02

8

-

2025-12-02

9

-

2025-12-02

10

-

2025-12-02

11

-

2025-12-02

12

-

2025-12-02

13

-

2025-12-02

14

-

2025-12-02

15

-

2025-12-02

16

-

2025-12-02

17

-

2025-12-02

18

-

2025-12-02

19

-

2025-12-02

20

-

2025-12-02

21

-

2025-12-02

22

-

2025-12-02

23

-

2025-12-02

24

-

2025-12-02

25

-

2025-12-02

26

-

2025-12-02

27

-

2025-12-02

28

-

2025-12-02

29

-

2025-12-02

30

-

2025-12-02

31

-

2025-12-02

32

-

2025-12-02

33

-

2025-12-02

34

-

2025-12-02

35

-

2025-12-02

36

-

2025-12-02

37

-

2025-12-02

38

-

2025-12-02

39

-

2025-12-02

40

-

2025-12-02

41

-

2025-12-02

42

-

2025-12-02

43

-

2025-12-02

44

-

2025-12-02

45

-

2025-12-02

46

-

2025-12-02

47

-

2025-12-02

48

-

2025-12-02

49

-

2025-12-02

50

-

2025-12-02

51

-

2025-12-02

52

-

2025-12-02

53

-

2025-12-02

54

-

2025-12-02

55

-

2025-12-02

56

-

2025-12-02

57

-

2025-12-02

58

-

2025-12-02

59

-

2025-12-02

60

-

2025-12-02

61

-

2025-12-02

62

-

2025-12-02

63

-

2025-12-02

64

-

2025-12-02

65

-

2025-12-02

66

-

2025-12-02

67

-

2025-12-02

68

-

2025-12-02

69

-

2025-12-02

70

-

2025-12-02

71

-

2025-12-02

72

-

2025-12-02

73

-

2025-12-02

74

-

2025-12-02

75

-

2025-12-02

76

-

2025-12-02

77

-

2025-12-02

78

-

2025-12-02

79

-

2025-12-02

80

-

2025-12-02

81

-

2025-12-02

82

-

2025-12-02

83

-

2025-12-02

84

-

2025-12-02

85

-

2025-12-02

86

-

2025-12-02

87

-

2025-12-02

88

-

2025-12-02

89

-

2025-12-02

90

-

2025-12-02

91

-

2025-12-02

92

-

2025-12-02

93

-

2025-12-02

94

-

2025-12-02

95

-

2025-12-02

96

-

2025-12-02

97

-

2025-12-02

98

-

2025-12-02

99

-

2025-12-02

100

-

2025-12-02

101

-

2025-12-02

102

-

2025-12-02

103

-

2025-12-02

104

-

2025-12-02

105

-

2025-12-02

106

-

2025-12-02

107

-

2025-12-02

108

-

2025-12-02

109

-

2025-12-02

110

-

2025-12-02

111

-

2025-12-02

112

-

2025-12-02

113

-

2025-12-02

114

-

2025-12-02

115

-

2025-12-02

116

-

2025-12-02

117

-

2025-12-02

118

-

2025-12-02

119

-

2025-12-02

120

-

2025-12-02

121

-

2025-12-02

122

-

2025-12-02

123

-

2025-12-02

124

-

2025-12-02

125

-

2025-12-02

126

-

2025-12-02

127

-

2025-12-02

128

-

2025-12-02

129

-

2025-12-02

130

-

2025-12-02

131

-

2025-12-02

132

-

2025-12-02

133

-

2025-12-02

134

-

2025-12-02

135

-

2025-12-02

136

-

2025-12-02

137

-

2025-12-02

138

-

2025-12-02

139

-

2025-12-02

140

-

2025-12-02

141

-

2025-12-02

142

-

2025-12-02

143

-

2025-12-02

144

-

2025-12-02

145

-

2025-12-02

146

-

2025-12-02

147

-

2025-12-02

148

-

2025-12-02

149

-

2025-12-02

150

-

2025-12-02

151

-

2025-12-02

152

-

2025-12-02

153

-

2025-12-02

154

-

2025-12-02

155

-

2025-12-02

156

-

2025-12-02

157

-

2025-12-02

158

-

2025-12-02

159

-

2025-12-02

160

-

2025-12-02

161

-

2025-12-02

162

-

2025-12-02

163

-

2025-12-02

164

-

2025-12-02

165

-

2025-12-02

166

-

2025-12-02

167

-

2025-12-02

168

-

2025-12-02

169

-

2025-12-02

170

-

2025-12-02

171

-

2025-12-02

172

-

2025-12-02

173

-

2025-12-02

174

-

2025-12-02

175

-

2025-12-02

176

-

2025-12-02

177

-

2025-12-02

178

-

2025-12-02

179

-

2025-12-02

180

-

2025-12-02

181

-

2025-12-02

182

-

2025-12-02

183

-

2025-12-02

184

-

2025-12-02

185

-

2025-12-02

186

-

2025-12-02

187

-

2025-12-02

188

-

2025-12-02

189

-

2025-12-02

190

-

2025-12-02

191

-

2025-12-02

192

-

2025-12-02

193

-

2025-12-02

194

-

2025-12-02

195

-

2025-12-02

196

-

2025-12-02

197

-

2025-12-02

198

-

2025-12-02

199

-

2025-12-02

200

-

2025-12-02

201

-

2025-12-02

202

-

2025-12-02

203

-

2025-12-02

204

-

2025-12-02

205

-

2025-12-02

206

-

2025-12-02

207

-

2025-12-02

208

-

2025-12-02

209

-

2025-12-02

210

-

2025-12-02

211

-

2025-12-02

212

-

2025-12-02

213

-

2025-12-02

214

-

2025-12-02

215

-

2025-12-02

216

-

2025-12-02

217

-

2025-12-02

218

-

2025-12-02

219

-

2025-12-02

220

-

2025-12-02

221

-

2025-12-02

222

-

2025-12-02

223

-

2025-12-02

224

-

2025-12-02

225

-

2025-12-02

226

-

2025-12-02

227

-

2025-12-02

228

-

2025-12-02

229

-

2025-12-02

230

-

2025-12-02

231

-

2025-12-02

232

-

2025-12-02

233

-

2025-12-02

234

-

2025-12-02

235

-

2025-12-02

236

-

2025-12-02

237

-

2025-12-02

238

-

2025-12-02

239

-

2025-12-02

240

-

2025-12-02

241

-

2025-12-02

242

-

2025-12-02

243

-

2025-12-02

244

-

2025-12-02

245

-

2025-12-02

246

-

2025-12-02

247

-

2025-12-02

248

-

2025-12-02

249

-

2025-12-02

250

-

2025-12-02

251

-

2025-12-02

252

-

2025-12-02

253

-

2025-12-02

254

-

2025-12-02

255

-

2025-12-02

256

-

2025-12-02

257

-

2025-12-02

258

-

2025-12-02

259

-

2025-12-02

260

-

2025-12-02

261

-

2025-12-02

262

-

2025-12-02

263

-

2025-12-02

264

-

2025-12-02

265

-

2025-12-02

266

-

2025-12-02

267

-

2025-12-02

268

-

2025-12-02

269

-

2025-12-02

270

-

2025-12-02

271

-

2025-12-02

272

-

2025-12-02

273

-

2025-12-02

274

-

2025-12-02

275

-

2025-12-02

276

-

2025-12-02

277

-

2025-12-02

278

-

2025-12-02

279

-

2025-12-02

280

-

2025-12-02

281

-

2025-12-02

282

-

2025-12-02

283

-

2025-12-02

284

-

2025-12-02

285

-

2025-12-02

286

-

2025-12-02

287

-

2025-12-02

288

-

2025-12-02

289

-

2025-12-02

290

-

2025-12-02

291

-

2025-12-02

292

-

2025-12-02

293

-

2025-12-02

294

-

2025-12-02

295

-

2025-12-02

296

-

2025-12-02

297

-

2025-12-02

298

-

2025-12-02

299

-

2025-12-02

300

-

2025-12-02

301

-

2025-12-02

302

-

2025-12-02

303

-

2025-12-02

304

-

2025-12-02

305

-

2025-12-02

306

-

2025-12-02

307

-

2025-12-02

308

-

2025-12-02

309

-

2025-12-02

310

-

2025-12-02

311

-

2025-12-02

312

-

2025-12-02

313

-

2025-12-02

314

-

2025-12-02

315

-

2025-12-02

316

-

2025-12-02

317

-

2025-12-02

318

-

2025-12-02

319

-

2025-12-02

320

-

2025-12-02

321

-

2025-12-02

322

-

2025-12-02

323

-

2025-12-02

324

-

2025-12-02

325

-

2025-12-02

326

-

2025-12-02

327

-

2025-12-02

328

-

2025-12-02

329

-

2025-12-02

330

-

2025-12-02

331

-

2025-12-02

332

-

2025-12-02

333

-

2025-12-02

334

-

2025-12-02

335

-

2025-12-02

336

-

2025-12-02

337

-

2025-12-02

338

-

2025-12-02

339

-

2025-12-02

340

-

2025-12-02

341

-

2025-12-02

342

-

2025-12-02

343

-

2025-12-02

344

-

2025-12-02

345

-

2025-12-02

346

-

2025-12-02

347

-

2025-12-02

348

-

2025-12-02

349

-

2025-12-02

350

-

2025-12-02

351

-

2025-12-02

352

-

2025-12-02

353

-

2025-12-02

354

-

2025-12-02

355

-

2025-12-02

356

-

2025-12-02

357

-

2025-12-02

358

-

2025-12-02

359

-

2025-12-02

360

-

2025-12-02

361

-

2025-12-02

362

-

2025-12-02

363

-

2025-12-02

364

-

2025-12-02

365

-

2025-12-02

366

-

2025-12-02

367

-

2025-12-02

368

-

2025-12-02

369

-

2025-12-02

370

-

2025-12-02

371

-

2025-12-02

372

-

2025-12-02

373

-

2025-12-02

374

-

2025-12-02

375

-

2025-12-02

376

-

2025-12-02

377

-

2025-12-02

378

-

2025-12-02

379

-

2025-12-02

380

-

2025-12-02

381

-

2025-12-02

382

-

2025-12-02

383

-

2025-12-02

384

-

2025-12-02

385

-

2025-12-02

386

-

2025-12-02

387

-

2025-12-02

388

-

2025-12-02

389

-

2025-12-02

390

-

2025-12-02

391

-

2025-12-02

392

-

2025-12-02

393

-

2025-12-02

394

-

2025-12-02

395

-

2025-12-02

396

-

2025-12-02

397

-

2025-12-02

398

-

2025-12-02

399

-

2025-12-02

400

-

2025-12-02

1

-

2025-12-02

2

-

2025-12-02

3

-

2025-12-02

4

-

2025-12-02

5

-

2025-12-02

6

-

2025-12-02

7

-

2025-12-02

8

-

2025-12-02

9

-

2025-12-02

10

-

2025-12-02

11

-

2025-12-02

12

-

2025-12-02

13

-

2025-12-02

14

-

2025-12-02

15

-

2025-12-02

16

-

2025-12-02

17

-

2025-12-02

18

-

2025-12-02

19

-

2025-12-02

20

-

2025-12-02

21

-

2025-12-02

22

-

2025-12-02

23

-

2025-12-02

24

-

2025-12-02

25

-

2025-12-02

26

-

2025-12-02

27

-

2025-12-02

28

-

2025-12-02

29

-

2025-12-02

30

-

2025-12-02

31

-

2025-12-02

32

-

2025-12-02

33

-

2025-12-02

34

-

2025-12-02

35

-

2025-12-02

36

-

2025-12-02

37

-

2025-12-02

38

-

2025-12-02

39

-

2025-12-02

40

-

2025-12-02

41

-

2025-12-02

42

-

2025-12-02

43

-

2025-12-02

44

-

2025-12-02

45

-

2025-12-02

46

-

2025-12-02

47

-

2025-12-02

48

-

2025-12-02

49

-

2025-12-02

50

-

2025-12-02

51

-

2025-12-02

52

-

2025-12-02

53

-

2025-12-02

54

-

2025-12-02

55

-

2025-12-02

56

-

2025-12-02

57

-

2025-12-02

58

-

2025-12-02

59

-

2025-12-02

60

-

2025-12-02

61

-

2025-12-02

62

-

2025-12-02

63

-

2025-12-02

64

-

2025-12-02

65

-

2025-12-02

66

-

2025-12-02

67

-

2025-12-02

68

-

2025-12-02

69

-

2025-12-02

70

-

2025-12-02

71

-

2025-12-02

72

-

2025-12-02

73

-

2025-12-02

74

-

2025-12-02

75

-

2025-12-02

76

-

2025-12-02

77

-

2025-12-02

78

-

2025-12-02

79

-

2025-12-02

80

-

2025-12-02

81

-

2025-12-02

82

-

2025-12-02

83

-

2025-12-02

84

-

2025-12-02

85

-

2025-12-02

86

-

2025-12-02

87

-

2025-12-02

88

-

2025-12-02

89

-

2025-12-02

90

-

2025-12-02

91

-

2025-12-02

92

-

2025-12-02

93

-

2025-12-02

94

-

2025-12-02

95

-

2025-12-02

96

-

2025-12-02

97

-

2025-12-02

98

-

2025-12-02

99

-

2025-12-02

100